Probable que hayas oído el término «LLM» o «Modelo Grande de Lenguaje». Suena a algo sacado de una película de ciencia ficción, pero la realidad es que esta tecnología ya está aquí y está transformando la forma en que trabajamos, creamos y nos comunicamos.

Estos sistemas no son meramente una evolución de los chatbots tradicionales, sino una categoría tecnológica fundamental que está redefiniendo la estrategia empresarial. Este análisis ofrece una visión estructurada de qué son los LLM, los principios de su arquitectura y un estudio comparativo de los modelos más influyentes del ecosistema actual. Vamos con ello.

¿Qué es un LLM o Large Language Model en IA?

Un Large Language Model (LLM), es un tipo avanzado de inteligencia artificial (IA) basado en arquitecturas de redes neuronales profundas diseñado para entender, generar y responder a texto en lenguaje humano de una manera sorprendentemente precisa y creativa. Son «grandes» porque han sido entrenados con una cantidad masiva de datos de texto, lo que les permite aprender los patrones, las relaciones y los matices de la comunicación humana.

La escala es un factor determinante:

- «Grande» se refiere tanto al tamaño del modelo (cientos de miles de millones de parámetros) como al volumen del entrenamiento (terabytes de datos que abarcan libros, artículos científicos, código fuente y la web abierta).

- «Lenguaje» denota su especialización en el dominio del lenguaje natural, aunque los modelos más recientes son multimodales y procesan también imágenes, audio y otros tipos de datos.

- «Modelo» indica que es un sistema estadístico que representa patrones y relaciones semánticas extraídas de los datos, lo que le permite generar resultados probabilísticamente coherentes en lugar de respuestas preprogramadas.

Para explicarlo con mayor sencillez, imagina que tienes un becario increíblemente rápido y con acceso a casi toda la información escrita en internet. Puedes pedirle que redacte un correo electrónico, que te resuma un libro denso, que escriba un poema o incluso que te ayude a programar una página web. Este becario no «copia y pega» de una única fuente, sino que entiende el contexto, el tono y la intención de tu petición para generar una respuesta completamente nueva y coherente.

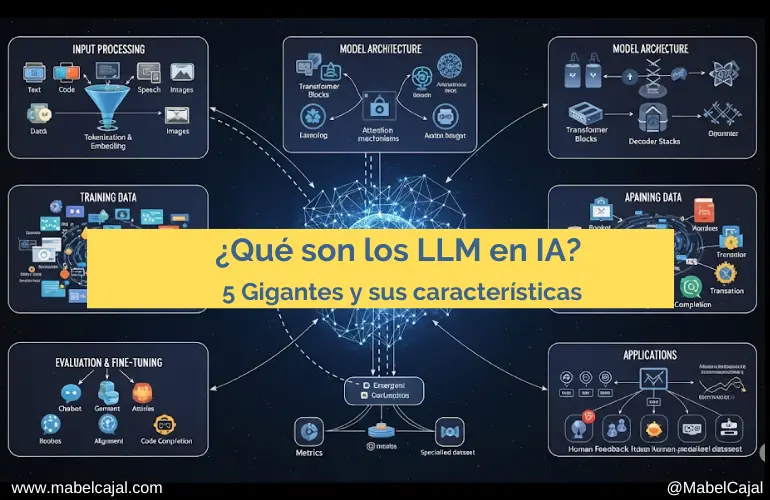

¿Cómo funcionan estos «cerebros digitales»? La magia de los Transformers

La mayoría de los LLM modernos funcionan gracias a una arquitectura de red neuronal llamada «Transformer». Piensa en ello como un sistema de atención muy sofisticado. Cuando le das una instrucción (un «prompt»), el modelo no solo mira las palabras individualmente, sino que presta atención a cómo cada palabra se relaciona con todas las demás en la oración y en el contexto más amplio que ha aprendido.

El proceso, a grandes rasgos, es el siguiente. Comienza con un entrenamiento masivo, es decir, se «alimenta» al modelo con una biblioteca digital gigantesca: libros, artículos, sitios web, conversaciones, etc. Durante esta fase, el modelo aprende a predecir la siguiente palabra en una secuencia. Al hacer esto miles de millones de veces, desarrolla una comprensión profunda de la gramática, los hechos, los estilos de escritura y el razonamiento. Pasa a la comprensión del Prompt, cuando escribes una petición, el modelo utiliza su mecanismo de «atención» para desglosar tu solicitud y entender la intención real detrás de tus palabras y finalmente genera una respuesta, basándose en su entrenamiento y en la comprensión de tu prompt, el modelo comienza a generar una respuesta palabra por palabra. Cada nueva palabra se elige en función de la probabilidad de que sea la más lógica y coherente en ese contexto.

El resultado es una capacidad asombrosa para conversar, crear contenido, analizar información y mucho más.

La magia del «Transformer»: El motor de la IA moderna

El gran salto adelante de la inteligencia artificial se debe a una tecnología revolucionaria que apareció en 2017: el Transformer. Para entender por qué fue tan importante, imaginemos la forma en que se leía antes y cómo se lee ahora.

- La forma antigua (Redes Neuronales Recurrentes): Era como leer un libro una palabra a la vez. Para entender lo que pasaba en la página 50, la IA tenía que recordar todo lo que había leído en las 49 páginas anteriores. Era un proceso lento y, a menudo, para cuando llegaba al final, ya había «olvidado» detalles importantes del principio.

- La nueva forma (El Transformer): Es como si la IA pudiera desplegar todas las páginas de un libro en el suelo de un gimnasio gigante. Puede ver todas las palabras a la vez y al instante. Esto le permite no solo leer mucho más rápido, sino también entender cómo una palabra en la página 3 se relaciona con una idea en la página 80. Ve el «cuadro completo» de inmediato.

¿Cómo funciona este «cerebro» por dentro?

El proceso se puede desglosar en cuatro pasos clave:

- Descomponer y Traducir: es lo que se llama tokenización y embeddings. Primero, la IA descompone la frase que le das en piezas o palabras individuales («tokens»). Luego, traduce cada pieza a un lenguaje que entiende: los números. Pero no es una simple traducción; es como si buscara cada palabra en un diccionario gigante que le dice no solo qué significa, sino también con qué otras palabras se relaciona. Así, las palabras «rey» y «reina» se convierten en números parecidos, mientras que «coche» tendrá números muy diferentes.

- Añadir el Orden: Si tiras todas las palabras de una frase a la vez sobre una mesa, pierdes el sentido («perro al gato el persigue»). Para evitar esto, la IA le pega a cada palabra una «etiqueta» con su posición original (1º, 2º, 3º…). De este modo, aunque las vea todas a la vez, siempre sabe en qué orden iban para no perder el significado.

- El Superpoder: La Auto-Atención (Self-Attention) es el verdadero núcleo de la magia. Una vez que tiene todas las palabras con su significado y su orden, el mecanismo de «auto-atención» crea una red de conexiones entre ellas. Es como si cada palabra «mirara» a todas las demás y decidiera cuáles son las más importantes para entender el contexto. Ejemplo: En la frase «El robot dejó caer la botella porque era de cristal», ¿qué era de cristal? La palabra «era» le presta muchísima atención a «botella» y a «cristal», y muy poca a «robot». Así, la IA entiende que «cristal» describe a la botella, no al robot. Este sistema le permite descifrar relaciones complejas, incluso si las palabras están muy separadas en un texto largo.

- Generar la Respuesta (Generación de Salida): Después de haber entendido profundamente todas estas relaciones, la IA empieza a construir su respuesta. Como un experto narrador, elige la siguiente palabra más lógica y coherente basándose en todo el contexto que ha analizado, y así sucesivamente, palabra por palabra, hasta formar una frase completa y con sentido.

También te puede interesar:

Cómo influye Gemini o ChatGPT para viajes (y qué debe hacer tu empresa turística)

Los 5 modelos LLMs más conocidos actualmente

El campo de los LLM está en plena ebullición y constantemente surgen nuevos modelos. Aquí tienes una lista de los 5 más conocidos actualmente:

1. Familia GPT (OpenAI): Incluye a GPT-3.5, GPT-4 y el más reciente GPT-4o.

2. Gemini (Google): La familia de modelos de Google, con versiones como Gemini Pro y Gemini 1.5.

3. Llama (Meta): Una serie de modelos de código abierto, con Llama 3 como su última iteración.

4. Claude (Anthropic): Conocidos por su enfoque en la seguridad y el razonamiento ético, con Claude 3 como su principal familia de modelos.

5. Mistral (Mistral AI): Una compañía europea que ha ganado rápidamente reconocimiento por sus potentes modelos, como Mistral Large.

¿Cuál es el mejor «Large Language Model y para qué?

Vamos a echar un vistazo para analizar sus diferencias y en qué destaca cada uno, lo que te dará una idea algo más precisa si necesitas encontrar tu LLM perfecto.

GPT-4o (OpenAI)

Es la última y más avanzada versión de OpenAI, sucesor del famoso GPT-4. Su principal característica es que es «omnicanal» de forma nativa, lo que significa que puede procesar y generar no solo texto, sino también audio e imágenes de manera fluida y en tiempo real.

Diferencia clave: Su velocidad y su capacidad multimodal en tiempo real son revolucionarias. Puede mantener una conversación hablada con una latencia mínima y entender el tono emocional.

Mejor para:

- Interacciones en tiempo real. Asistentes de voz súper avanzados, traducción simultánea.

- Análisis de datos visuales: Explicar gráficos, analizar imágenes y hojas de cálculo.

- Creatividad multimodal: Generar contenido que mezcla texto e imágenes de forma nativa.

- Uso general: Es un modelo extremadamente versátil y potente para casi cualquier tarea.

Claude 3 (Anthropic)

La familia Claude 3 se compone de tres modelos: Haiku (el más rápido), Sonnet (equilibrado) y Opus (el más potente). Son conocidos por su gran «ventana de contexto» (pueden recordar y procesar textos muy largos) y su enfoque en la seguridad para evitar respuestas dañinas.

Diferencia clave: Su énfasis en la seguridad y el razonamiento complejo. A menudo se le considera más «reflexivo» y menos propenso a generar información incorrecta o problemática. Su modelo Opus compite directamente con GPT-4 en tareas de alta complejidad.

Mejor para:

- Tareas empresariales y legales: Análisis de contratos, resúmenes de documentos largos y detallados.

- Investigación y academia: Procesar y analizar grandes volúmenes de información con alta precisión.

- Desarrollo de software: Ayuda en la programación y la automatización de procesos complejos.

- Aplicaciones que requieren un alto grado de fiabilidad.

Llama 3 (Meta)

Es la última generación de los modelos de código abierto de Meta (Facebook). Al ser de código abierto, permite a desarrolladores y empresas construir sobre él, modificarlo y ejecutarlo en sus propios sistemas.

Diferencia clave: Su naturaleza de código abierto democratiza el acceso a la IA de alto nivel. Ofrece un rendimiento muy competitivo, acercándose a los mejores modelos privados, pero con la flexibilidad de ser personalizable.

Mejor para:

- Desarrolladores y startups: Permite crear aplicaciones de IA personalizadas sin depender de las API de grandes empresas.

- Investigación académica: Facilita la experimentación y el avance del conocimiento en el campo de la IA.

- Aplicaciones que requieren un control total sobre el modelo: Por motivos de privacidad o especificidad del caso de uso.

- Tareas de generación de texto y paráfrasis a gran escala.

Gemini (Google)

La respuesta de Google a GPT. Gemini es una familia de modelos diseñados desde cero para ser multimodales. Se integra profundamente en todo el ecosistema de Google (desde la búsqueda hasta Android).

Diferencia clave: Su profunda integración con el vasto conocimiento y los servicios de Google. Tiene un potencial inmenso para acceder a información en tiempo real y realizar acciones en el mundo real a través de las herramientas de Google.

Mejor para:

- Búsqueda y recuperación de información: Obtener respuestas conversacionales y resúmenes basados en la información más reciente de la web.

- Productividad personal y de oficina: Integración con Gmail, Google Docs, etc., para automatizar tareas.

- Flujos de trabajo complejos: Diagnosticar errores, planificar proyectos y optimizar procesos.

- Aplicaciones que se benefician del ecosistema de Google.

Mistral Large (Mistral AI)

Proveniente de una startup parisina, Mistral AI se ha hecho un nombre por crear modelos extremadamente eficientes y potentes. Mistral Large es su buque insignia y compite cara a cara con los mejores del mundo.

Diferencia clave: Un rendimiento de primer nivel con un enfoque en la eficiencia. A menudo destaca en tareas de razonamiento y en el manejo de múltiples idiomas y lenguajes de programación.

Mejor para:

- Aplicaciones multilingües complejas: Traducción y resumen en una amplia variedad de idiomas.

- Tareas de codificación y matemáticas: Generación y depuración de código en más de 80 lenguajes de programación.

- Resumen y estructuración de texto: Extraer la información clave de documentos complejos.

- Empresas que buscan un modelo de alto rendimiento con opciones de implementación flexibles.

¿Qué son las «alucinaciones» de un LLM y cómo se pueden mitigar en un entorno empresarial?

Una «alucinación» es un término utilizado para describir un fenómeno en el que un Modelo Grande de Lenguaje genera información que es factualmente incorrecta, completamente inventada o que no se basa en los datos de entrada proporcionados, pero la presenta con una aparente autoridad y coherencia. Es fundamental entender que esto no es un «error» en el sentido tradicional, sino una consecuencia directa de su diseño. Los LLM son motores de predicción probabilística, optimizados para generar la secuencia de palabras más lógica y gramaticalmente correcta, no para ser una base de datos de la verdad absoluta.

En un contexto empresarial, las alucinaciones representan un riesgo significativo. Pueden llevar a la difusión de información errónea a clientes, a la toma de decisiones de negocio basadas en datos falsos o a un daño reputacional para la marca. Por lo tanto, su mitigación es un aspecto crítico de la implementación de la IA.

Generación Aumentada por Recuperación (RAG – Retrieval-Augmented Generation)

Para mitigar este problema, la estrategia más efectiva es la Generación Aumentada por Recuperación (RAG – Retrieval-Augmented Generation). Este enfoque transforma al LLM de un «estudiante en un examen a libro cerrado» a uno en un «examen a libro abierto». En lugar de permitirle responder desde su conocimiento general, el sistema RAG le obliga a:

- Recuperar información relevante de una base de datos controlada y de confianza (documentos internos, políticas de empresa, manuales técnicos).

- Generar una respuesta basándose exclusivamente en esa información verificada.

Además de RAG, la fiabilidad se refuerza mediante una ingeniería de prompts precisa, que instruye al modelo a no salirse de los datos proporcionados, y el ajuste de parámetros como la «temperatura» a un nivel bajo para reducir la creatividad y favorecer las respuestas más predecibles.

El camino a la especialización: «Fine-Tuning» vs. RAG

Mientras que RAG es la solución principal para la fiabilidad factual, a menudo surge la pregunta sobre otra técnica avanzada: el fine-tuning (o ajuste fino). Es crucial entender que estas dos técnicas resuelven problemas diferentes y no son intercambiables.

El fine-tuning consiste en re-entrenar un modelo ya pre-entrenado con un conjunto de datos más pequeño y específico. Su objetivo no es inyectar nuevos conocimientos (esa es la función de RAG), sino adaptar el comportamiento, estilo, tono y formato de las respuestas del modelo. Si el modelo pre-entrenado es un graduado universitario con un vasto conocimiento general, el fine-tuning es el curso de formación que le enseña el estilo de comunicación y los procedimientos específicos de su empresa.

La elección entre RAG y fine-tuning se resume en:

- Use RAG cuando quiera controlar qué sabe el modelo. Es la mejor opción para que la IA responda preguntas sobre sus productos, datos internos o cualquier información factual. Es más rápido, barato y evita que el modelo «olvide» su entrenamiento general.

- Use Fine-Tuning cuando quiera controlar cómo responde el modelo. Es necesario solo cuando se busca un alto grado de especialización en el comportamiento de salida, por ejemplo:

- Formato Estricto: Para que genere respuestas siempre en un formato complejo y predefinido como JSON o XML.

- Voz de Marca: Para que adopte una personalidad muy definida (un tono formal, humorístico o una jerga específica).

- Tareas Lingüísticas de Nicho: Para mejorar su rendimiento en tareas como la traducción de jerga legal muy específica, donde el matiz estilístico es clave.

En conclusión, una estrategia de IA empresarial robusta no se basa en una única técnica, sino en una combinación inteligente. Generalmente, se comienza con una base sólida de RAG para garantizar la fiabilidad y el conocimiento contextual, se refina con una ingeniería de prompts experta y, solo cuando es estrictamente necesario, se recurre al fine-tuning para alcanzar un nivel de especialización estilística que de otro modo sería inalcanzable.

Conclusión: Los LLMs una herramienta imprescindible

Los Modelos Grandes de Lenguaje no son una moda pasajera; son una revolución tecnológica en ciernes. Desde potenciar chatbots más humanos hasta acelerar descubrimientos científicos, sus aplicaciones son casi ilimitadas.

Para ti, como usuario o emprendedor, entender las fortalezas y debilidades de cada modelo es clave para elegir la herramienta adecuada para el trabajo. Ya sea que necesites la creatividad multimodal de GPT-4o, la fiabilidad de Claude 3, la flexibilidad de Llama 3, la integración de Gemini o la eficiencia de Mistral Large, hay un LLM esperando para ayudarte en tu tarea.

FAQs sobre LLMs (Large Language Models – Modelos de lenguaje Largos)

¿Cómo elijo el LLM adecuado para mi negocio?

Para elegir el LLM adecuado, debe alinear el modelo con su prioridad. Para máxima calidad y razonamiento, use modelos de gama alta como GPT-4o o Claude 3 Opus. Si necesita analizar documentos largos, elija modelos con gran «ventana de contexto» como Claude 3 o Gemini 1.5 Pro. Para un control total y personalización, opte por un modelo de código abierto como Llama 3 para ejecutarlo en su propia infraestructura. Finalmente, para eficiencia y coste en alto volumen, considere modelos optimizados como Claude 3 Haiku.

¿Qué es la «ventana de contexto» y por qué importa?

La «ventana de contexto» es, en esencia, la memoria a corto plazo del modelo: la cantidad de información que puede procesar en una sola consulta. Una ventana de contexto grande es un factor crucial porque permite al modelo analizar documentos extensos como libros, mantener conversaciones más largas y coherentes sin olvidar detalles, o entender bases de código complejas de una sola vez.

¿Cuál es la diferencia entre un LLM y una AI?

La Inteligencia Artificial (IA) es el campo completo y general de la ciencia que busca crear máquinas capaces de realizar tareas que requieren inteligencia humana, mientras que un Modelo Grande de Lenguaje (LLM) es una aplicación muy específica y avanzada dentro de la IA. En otras palabras, la IA es como la categoría «Deporte», que abarca desde el fútbol hasta la natación, y un LLM sería como un «jugador de ajedrez de Gran Maestro»: una forma de inteligencia increíblemente especializada y potente, pero solo una de las muchas disciplinas que existen en el amplio mundo del deporte. Por lo tanto, todo LLM es IA, pero no toda la IA es un LLM.